LLM 强化学习中 Reward 准确性对训练效果的影响

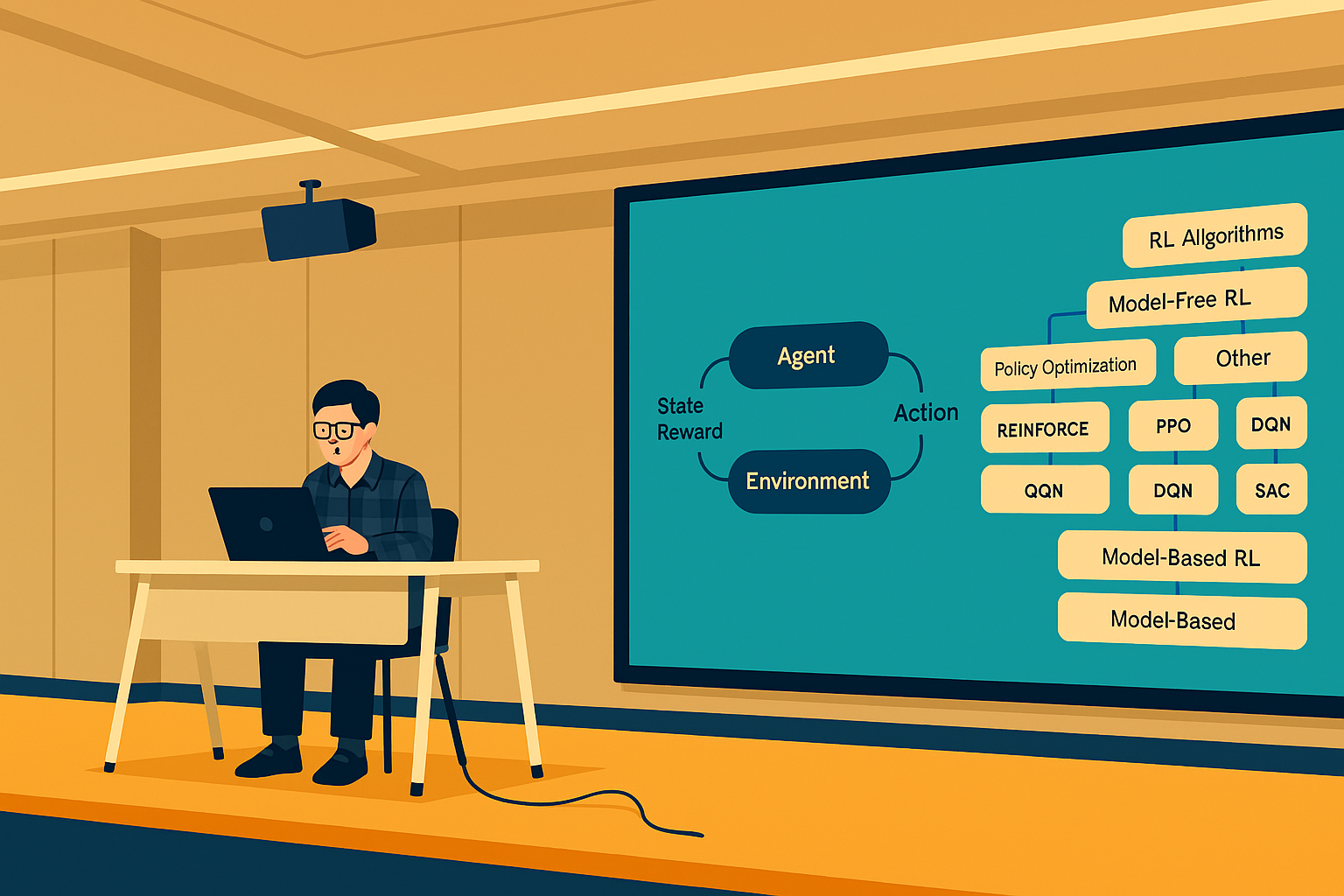

一、简介 1.1 背景 2025 年春节期间,DeepSeek-R1 [1] 引发了 LLM 领域的强化学习热潮。DeepSeek-R1 通过强化学习训练,直接激发模型自主推理能力;其核心算法 GRPO 结合基于规则的奖励函数(rule-based reward),让模型在数学竞赛 AIME 2024 中从 15.6% 准确率飙升至 86.7%。更惊艳的是,R1-Zero(无监督微调,纯强化学习)通过自我迭代涌现出“反思”能力(被称为’Aha moment’),主动修复推理错误,验证了大模型 RL 驱动的自主进化潜力。在多项权威测试中,DeepSeek-R1 以 97.3% 的 Math-500 准确率超越 OpenAI o1(96.6%),Codeforces 编程任务表现与人类顶尖选手持平。种种迹象表明,大模型强大的生成理解能力成为强化学习最强大的“先验”,大模型本身的强大能力能够被强化学习激励出来。 ...